Previous: 1.2 Депозитарий статей-первоисточников (на английском языке)

UP:

1 Введение. Общие принципы построения каналов передачи данных и сетей |

Previous: 1.2 Депозитарий статей-первоисточников (на английском языке)

UP:

1 Введение. Общие принципы построения каналов передачи данных и сетей |

1.3 Проблемы в ИТ

Семенов Ю.А. (ГНЦ ИТЭФ)

Многие из читателей слыхали о проблемах Гилберта, которые он сформулировал почти сто лет тому назад. Некоторые считались неразрешимыми. Одну из этих проблем (гипотезу Пуанкаре) решил замечательный российский математик Г.Я.Перельман. Именно этот факт подтолкнул меня к формулированию некоторых проблем ИТ. Выпускники университетов могут посмотреть эту статью и, возможно, выберут для себя направление будущей работы или даже предложат решение одной из названных ниже задач. Готов рассмотреть и добавить другие проблемы, если они окажутся интересными (обязательно с указанием автора). Возможно, целесообразно создать описание актуальных проблем и для других областей науки.

В любой отрасли человеческой деятельности всегда существуют проблемы, ИТ не исключение. Но здесь ситуация станет критической в 20-е годы 21-го века, когда будут исчерпаны традиционные ресурсы развития: повышение плотности активных элементов на чипе и пропускная способность каналов. Серьезную проблему представляют программные ошибки, криптография и сетевые угрозы. Все это создаст дополнительный стимул развития. Темпы развития многих технологий за последние два десятка лет драматически возросли, этому способствовал Интернет, который повысил скорость распространения научных и технологических знаний. Сегодня, если нужно нанести существенный урон государству, достаточно это государство изолировать от Интернет.

Небольшое резюме ИТ проблем представлено ниже (август 2014 г).

В последние годы произошел потрясающий прогресс в информационных технологиях. За 20 лет быстродействие вычислительной техники увеличилось в 1000 раз, пропускная способность каналов возросла в 10 000 раз, уже более 50 лет действует эмпирический закон Мура (удвоение плотности активных элементов на кристалле каждые полтора года).

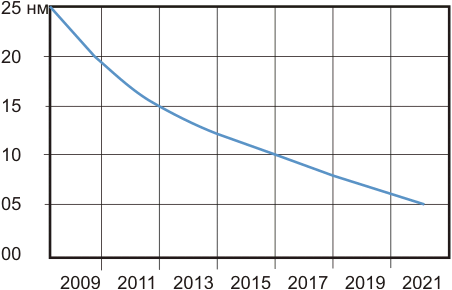

Используемая технология на кремнии позволяет работать с разрешением ~15 нм (середина 2014 года). Но постоянная кристаллической решетки кремния ~0,54 нм, что вводит физическое ограничение на пространственное разрешение. В 20- годы лидерам удалось реализовать 5-нанометровую технологию.

Рис. 1. Экстраполяция закона Мура до 2021-го года

На рис.1А представлена усредненная временная вариация числа транзисторов на чипе в период с1970 по 2020 гг, ("The Internet Protocol Journal", Volume 28, Number 1, p26)

Рис. 1A. Ситуация с законом Мура к 2025 году.

Предполагается, что действие закона Мура прекратится после 2020 года (см. рис. 1). Достаточно трудно представить себе активный элемент на кремнии размером менее 5 нм. В реальности это произошло в 2023 году.

Разработчик чипов компании Arm Майк Мюллер считает, что закон Мура прекратил свою работу (см. "'Moore's Law is dead': Three predictions about the computers of tomorrow", Nick Heath, September 19, 2018). Компания Arm поставляет свои процессоры практически для всех мобильных телефонов. Закон Мура успешно проработал около 50 лет и вышел на плато (см. рис. 1А) при разрешении около 10 нанометров (ограничение, сопряженное с постоянной кристаллической решетки кремния). Разрабатывается технология, при которой процессор и память размещаются в разных слоях (3D-технология). Трудности для разработчиков чипов будут нарастать лавинообразно. Видно, что технологические проблемы также нарастают, прогноз 2015 года пессиместичнее прогноза 2013-го. 5-нанометровая технология, видимо, не будет реализована. На самом деле разработчикам удалось дойти до 5 нм - это почти подвиг.

70% поверхности кристалла процессора сегодня занята проводниками, соединяющими активные элементы, что также препятствует росту плотности элементов на кристалле.

Повышение емкостей памяти вызывает миниатюризацию ячеек памяти, а уменьшение размера уменьшает заряд, там хранящийся, а это приводит к ухудшению отношения сигнал шум. Неслучайно первый квантовый компьютер работает при температуре 10мК0. Здесь полезно помнить, что уровень теплового шума пропорционален kTB, где k - постоянная Больцмана, Т - абсолютная температура, а B - полоса сигнала на входе приемника (существуют и другие источники шума, но они обычно вносят меньший вклад). B характеризует верхнюю частотную границу спектра исследуемого сигнала. Если сигнал стационарный, можно принудительно понижать B, путем усреднения или фильтрации (быстродействие системы при этом понижается). Самый доступный метод уменьшения уровня шумов - снижение температуры T.

Где выход? Возможно это уход в 3D (многослойные кристаллические структуры, что уже используется в SSD). Но многослойность усугубит проблему рассеивания тепла, выделяемого в кристалле.

Постоянная поляризации диэлектрика равна 10-13 сек, а предельная скорость обмена сегодня составляет около 2×1012 бит/c (2013 год). Здесь нужно учесть, что этот канал использовал несколько потоков данных через волокно. При окне прозрачности кремния ~150нм можно обеспечить до 100 потоков через оптоволокно. Ясно, что возможности прежнего темпа роста скорости передачи данных в ближайшие годы будут исчерпаны.

Около 10 лет назад, когда тактовая частота процессоров приблизилась к 3 ГГц, стало ясно, что дальнейший темп роста тактовой частоты более невозможен. В 2004 году разработчики, чтобы обеспечить рост производительности, перешли на многоядерную архитектуру. Но рост производительности в зависимости от числа процессоров имеет логарифмический характер.

До сих пор не доказаны теоремы криптографической прочности для всех используемых крипто-алгоритмов. Прогресс в области роста производительности вычислительной техники делает существующие алгоритмы менее эффективными (см. рис. 2).

Рис. 2. Деградация эффективности крипто-алгоритмов (см. Network Security, V2004, Issue 12, декабрь 2004, стр. 6-11)

Эта проблема становится критической в свете все более широкого использования криптографии во всех областях человеческой деятельности и грядущего появления квантовых компьютеров, которые сделают некоторые нынешние алгоритмы и крипто-ключи непригодными.

Все больше сторон человеческой жизни зависит от компьютеров и сетей. Программы становятся все более сложными и по этой причине более уязвимыми. Через сети управляются системы энерго- и водоснабжения, городской транспорт, финансовые учреждения и т.д. В 2012 году доходы киберпреступников превысили доходы от наркотрафика и этот криминальный бизнес стал привлекать большое число высококлассных программистов. По этой причине городское хозяйство может стать объектом атаки террористов, находящихся за пределами национальных границ.

Благодаря полиморфности детектируется только 24% всех вредоносных кодов, что облегчает APT-атаки. Беда в том, что последние годы разработкой вредоносных кодов занялись государственные структуры. Если бы все провайдеры могли договориться, с хакерами можно было бы покончить. Хакерство и SPAM существенно удорожают услуги Интернет.

Моделирование – наряду с теорией и экспериментом стало один из основных источников научных знаний об окружающем мире. Чем сложнее моделируемый процесс, тем более мощный компьютер необходим.

Самый мощный компьютер в мире (2013-14гг) Tianhe-2 (КНР) – 54,9 петафлопс; энерго потребление 24 МВт. Прошло 10 лет (май 2024 года) производительность выросла в разы, но этого уже мало.

Современный суперкомпьютер может содержать более 100000 узлов. При этом следует иметь в виду, что каждый из них имеет конечную надежность. В 2001 году время наработки на отказ супер-ЭВМ равнялось 5 часам, а в 2012 - 55 часов. Для 100000-узлового компьютера только 35% активности будет приходиться на продуктивную работу. Остальное время займет формирование точек восстановления (checkpoint) и другие вспомогательные операции.

Энергопотребление имеет несколько составляющих. Одна из основных - перезарядка паразитных емкостей в процессоре. Энергия сопряженная с перезарядкой паразитных емкостей определяется формулой E ~ N×U×C2/2. N - число разрядов процессора (N=64÷128); С - паразитная емкость; U - разница потенциалов между значениями логического нуля и единицы. Уменьшать С скоро станет невозможно (смотри выше заметки о перспективе закона Мура), сокращать U становится также трудно из-за проблем с отношением сигнал-шум. А двигаться в сторону абсолютного нуля или хотя бы жидкого азота не кажется перспективным. В процессоре существует еще много "паразитных" элементов, потребляющих энергию. Изменяя архитектуру и схемотехнику процессора можно понижать энергопотребление. Это на сегодня почти единственный ресурс повышения энергоэффективности процессора. Но и здесь близок теоретический предел. В результате потребляемая мощность суперкомпьютеров растет примерно пропорционально логарифму их вычислительных возможностей. Разумеется, сюда входят также издержки на охлаждение, кондиционирование и освещение.

Сегодня очень много людей умеют писать компьютерные программы, но никто не умеет избежать программных ошибок. Программы управляют воздушными лайнерами, ядерными реакторами, энергетическими сетями, водоснабжением и системами реанимации, помогают хирургам и ставят диагноз заболевания.

Ниже представлена таблица, где указаны объемы программных продуктов и средние значения чисел ошибок на 1000 строк кода. Нужно помнить, что помимо ОС существует огромное число программных приложений. Наша жизнь все в большей степени зависит от работы программ. На очереди появление носимых мониторов состояния здоровья и разработка лекарств, согласованных с генным набором конкретного человека, чтобы исключить аллергии. Но умереть от программной ошибки не выглядит привлекательным. В таблице ниже представлены данные по числу ошибок в современных операционных системах.

| Программный продукт | Число строк кода | Число ошибок на 1000 строк кода |

| Windows XP | 45 млн | 0,5 |

| Linux Kernal (до тестирования) | 5,7 млн | ~7 |

| NASA JPL | 0,003 | |

| Среднее по индустрии | 15-50 | |

| Вся авионика США (на земле и бортовая) | ~1 млрд |

Возможно, проблема может быть решена путем перехода от языков описания алгоритма к языкам описания проблемы, где выбор алгоритма возлагается на компьютер (минимизируется человеческий фактор - главный источник ошибок). Для этого компьютеру будут нужны некоторые черты искусственного интеллекта и должен быть создан банк всех известных алгоритмов. Это уменьшит на порядки число программных ошибок, также как сегодня мы не сталкиваемся с ошибками в программах вычисления значений стандартных функций (ошибки оттуда давно убраны). Точно также будут со временем убраны ошибки из текстов программ стандартных алгоритмов. Кто-то может подумать, что создание искусственного интеллекта может решить эту проблему. Но можно ли быть уверенным, что компьютер с искусственным интеллектом, созданным по модели человеческого мозга, будет ошибаться реже, чем обычный программист? Практически все программные ошибки, которые отравляют нам жизнь сегодня, сдеаны людьми-программистами...

История беспроводных сетей насчитывает десятилетия. Но последние полтора десятка лет были особенно богаты событиями. Сначала появился стандарт WiFi (802.11ac; f=5ГГц; B=3,4 Гбит/c), затем - WiMax. Параллельно развивалась мобильная телефония (2G->3G->4G->5G). 5G соответствует ~10 Гбит/c. Здесь полезно напомнить, что полоса пропускания канала определяется формулой Δf = cΔλ/λ2, из которой следует что, оптоволокна всегда будут обеспечивать на порядки большее быстродействие.

Рис. 3. Прогноз развития беспроводных технологий до 2015 года

Рис. 4. Новые направления развития и проблемы ИТ (2018г)

Previous: 1.2 Депозитарий статей-первоисточников (на английском языке)

UP:

1 Введение. Общие принципы построения каналов передачи данных и сетей |