Previous: 4.7.12 Мета язык программирования

UP:

4.7 Прикладные сети Интернет |

Previous: 4.7.12 Мета язык программирования

UP:

4.7 Прикладные сети Интернет |

4.7.13 Искусственный интеллект

Семенов Ю.А. (ГНЦ ИТЭФ)

| "Если бы свой интеллект был хорош, - не изобретали бы искусственного" | ||

| Ю.Шнейдер |

В 1950 году появилась основополагающая работа Алана Тьюринга "Computing Machinery and Intelligence".

Первые работы на тему искусственного интеллекта (ИИ) принадлежат Марвину Мински (Marvin Minsky), который в 1960 году опубликовал статью "Steps Toward Artificial Intelligence” ("Proceedings of the IRE", January 1960). Первые заявления о возможности создания искусственного интеллекта прозвучали в 50-ые годы. Сам термин искусственный интеллект появился на конференции в Дартмуте в 1956 году. Следует иметь в виду, что компьютеры обычно хороши для получения ответов, но бесполезны при формулировании самих вопросов.

Стивен Хокинг в своей книге “Мир в ореховой скорлупке”, 2001г написал: “Через двадцать лет тысячедолларовый компьютер может сравняться по сложности с человеческим мозгом. Параллельные процессоры будут имитировать работу нашего мозга и позволят компьютерам действовать так, будто те обладают разумом и сознанием”. Двадцать лет уже прошло… Прогнозирование штука не простая даже для гения...

В 1941 году немецкий ученый Конрад Цузе создал компьютер Z-3, Исследования он вел на деньги Немецкого института самолетостроения. Компьютер использовался для изучения флаттера крыла самолета. Предложение Цузе о финансировании замены реле в компьютере на электронные лампы не было поддержано нацистским правительством, которое сочло компьютерные технологии не имеющими военного значения.

Митио Каку в книге "Будущее разума" [3] написал. "В ближайшие несколько десятков лет роботы будут постепенно подниматься от уровня мыши, до кошки, а затем и обезьян и начнут ставить перед собой собственные задачи". Сегодня роботы могут манипулировать фактами быстрее человека, но не понимают, что они делают. Робот может работать с ощущениями (такими как цвет или звук) лучше человека, но не может по-настоящему "чувствовать" или "воспринимать" суть этих ощущений.

В 2009 году был смоделирован мозг кошки, содержащий 1,6 млрд нейронов и 9 трлн связей, для этого потребовалось 24576 процессоров. Только нужно понимать, что такая система мышей ловить не умела. Позднее исследователи из IBM, воспользовавшись компьютером Blue Gene, смоделировали 4,5% нейронов и синапсов человеческого мозга. Компьютер Blue Gene./Q Sequoia имеет производительность 20 петафлопс и потребляет 7,9МВт (как небольшой город). В череп человека эта штука точно не поместится. Для такого процессора потребуется просторное здание. Удивительно то, что геном человека, имея 23000 генов, ухитряется как-то управлять формированием мозга, где содержится 10 млрд нейронов и чудовищное число связей. Данная задача решается путем использования большого числа стандартных модулей - колонок нейронов длиной около 2 мм, 0,5 мм в диаметре, каждый такой модуль содержит 60000 нейронов. Потребовалось десять лет, чтобы составить карту нейронов в такой колонке.

Нейроны оперируют как цифровыми, так и аналоговыми данными, ни один из традиционных компьютером так работать не может.

Результат расшифровки генома человека - гигантский словарь, содержащий более 20000 слов, в нем немало пустых страниц, но все гены выписаны безукоризненно. Для выявления связей между нейронами и их функций в США и Евросоюзе выделены многие миллиарды и это только начало.

В 1965 году появилась экспертная система по молекулярной химии DENDRAL (MIT US).

Первый робот RB5X был создан в 1984 году. Он умел кое-что прогнозировать.

С самого начала нужно признать, что пока не существует точного определения искусственного интеллекта. Интуитивно - это нечто, что может решать задачи подобно человеческому мозгу, в том числе и такие, которые ранее не встречались. На мой взгляд компьютер с искусственным интеллектом должен уметь самообучаться. Способность решить какую-то одну сколь угодно сложную задачу не может говорить о наличие искусственного интеллекта. В настоящее время разрабатываются специальные алгоритмы "глубокого обучения" (deep-learning; см. "Smarter algorithms will power our future digital lives", Sharon Gaudi, Computerworld, Sep 26, 2014). Другим непременным признаком ИИ является универсальность, способность решать любые проблемы, а также способность самостоятельно формулировать задачи.

Суперинтеллектом считается система, которая способна решать некоторый класс задач, лучше чем это делает человек. В этом определении, надо признать, скрыта большая неопределенность, но число конкретных задач, которые компьютер может решить быстрее или лучше человека быстро увеличивается. Некоторые фантазеры уверены, что вот-вот будут созданы роботы умнее и мощнее людей. О проблеме сингулярности, смотри обсуждение ниже. Еще в начале 1950-х фон Нейман сказал "любое ускорение технологисчекого прогресса и изменения образа жизни людей создает впечатление приближения некой важнейшей сингулярности в истории человеческой расы, за пределами которой человеческая деятельность в том виде, какой мы знаем ее сегодня, больше не может продолжаться". Ученый-компьютерщик Хала Финни в1992 году написал, что компьютер должен быть инструментом, который освободит и защитит людей, но не будет их контролировать.

В 1997г компьютерная программа Deep Blue одержала победу над шахматным чемпионом мира того времени Гарри Каспаровым. Мощность машин с тех пор увеличилась на порядки, но превзойти человеческий мозг при решении любых задач они пока не смогли.

Следует учесть, что подавляющее число проблем, с которыми сталкиваются люди, могут быть решены одним из уже известных методов или комбинацией таких методов.

Некоторые эксперты считают, что к 2029 году компьютеры смогут обрабатывать тот же объем данных, что и человеческий мозг, а через еще 16 лет они станут "умнее" человека. Ханс Моравек в 1994 году утверждал, что для реализации человеческой личности тело, как таковое не нужно.

Четыре года тому назад в нейронных сетевых моделях использовалось 10 млн. соединений, в 2011 (проект Google Brain) - 1 миллиард, а сейчас готовится модель, где будут использоваться около 10 миллиардов соединений. По последним данным в мозге человека 86 млрд. нейронов, не считая вспомогательные клетки глии, которых столько же или несколько больше.

Мозг человека составляет 2% от веса тела и содержит около 100 млрд нейронов [3 (столько же звезд содержит наша Галактика]. Между ними может существовать до 1015 связей. Информация о мозге занимает 80% наших генов, мозг потребляет около 20% вырабатываемой энергии. Основным инструментом для исследования работы мозга стал МР-томограф. Пространственное разрешение МРТ приближается к одному миллиметру, а вот временное оставляет желать лучшего.(~1сек). Технология электроэнцефалографии (ЭЭГ) предлагает хорошее временное разрешение, но совершенно неудовлетворительное пространственное разрешение, но эта техника на порядки дешевле, чем МРТ. Следует учитывать, что для создания ИИ нужно сначала разобраться с тем, как работает естественный интеллект.

M Mински - один из основателей Лаборатории искусственного интеллекта МТИ, как-то сказал, что человеческий разум похож на общество разумов, состоящее из модулей, которые постоянно борются между собой [3]. "Сознание - это то, что делает мозг". Сознание формирует модель мира в пространстве и времени и, прежде всего, для будущего, используя большое число обратных связей.

По уровню сознания (развитию мозга) живые объекты делятся на 4 уровня. От 0 - для растений (неподвижные организмы), I - для пресмыкающихся, II - для млекопитающих и III - для человека. На уровне III создается модель своего места в мире с последующим прогнозированием будущего. Величайшее достижение человеческого мозга - его способность вообразить объекты, не существующие в реальности, именно это позволяет ему думать о будущем [3]. Для моделирования будущего надо понимать законы природы и владеть здравым смыслом. Способность моделировать будущее - одна из основных движущих сил эволюции мозга и интеллекта.

Я с удивлением узнал (да простят меня - дилетанта), что сетчатка глаза имеет 130 млн. фоторецепторов и данные оттуда пересылаются в таламус по зрительному нерву со скоростью 180Мбит/с. Оттуда данные идут в затылочную долю мозга, где размещена зрительная кора.

Истинный ИИ должен владеть также и набором чувств (эмоций). Страх позволяет объекту ИИ сохранить себя, Очевидно, что роботы должны уметь лгать, без этого навыка им трудно будет находиться в обществе людей..

Существует много разных определений ИИ, делаются попытки упорядочить эти представления (см. "A guide to artificial intelligence in the enterprise", Linda Tucci, 09 Jul 2021)

| Реактивные АИ | С ограниченной памятью | Теория интеллекта |

|

|

|

22-го сентября 2011 г. появилась заметка компании IBM о компьютере Watson (см. Talking computer will change the world; promises not to kill you). Машина была названа Watson в честь первого президента компании IBM Thomas'а J. Watson. Разработчики (во главе с David'ом Ferrucci) позиционируют Watson как компьютерную систему искусственного интеллекта. Он ориентирован на работу с текстами на естественном языке. Watson может обрабатывать до миллиона книг в сек (500 гигабайт). Компания IBM предлагает свой суперкомпьютер Watson в качестве платформы для разработки облачных приложений, ориентированных на когнитивный компьютинг. Важным преимуществом компьютера Watson является его способность к обучению. Именно благодаря этому разработчикам этой системы удалось добиться того, что он смог обыграть в Jeopardy чемпионов США. Фокус в том, что компьютер об этом даже не знал. Watson используется, по данным IBM, организациями 25 стран, включая Австралию, Англию, Таиланд, Канаду и Испанию. Я видел такой компьютер в Москве (был подарен компанией IBM).

| Накопление данных в различных научных отраслях и аналитические исследования методом когнитивных вычислений может стать источником новых знаний. Фильмы и фантастические романы повествуют об угрозах роботов и искусственного интеллекта, на самом деле несравненно большую опасность представляют программные ошибки. |

Компания IBM после своей победы в Jeopardy (Watson) включилась в разработку аналитических программ для бизнеса на естественном языке (см. "IBM Watson Analytics now open for business", Matt Weinberger, Computerworld, Dec 4, 2014). Эти программы базируются на Big Blue AI. Программе можно задавать вопросы типа "What employees are likely to leave the company? и получить графики и диаграммы по этой проблеме. Программа может работать через WEB-браузер. При решении проблемы используются данные из депозитариев IBM, а также от Google Drive, Box, Oracle.

Впрочем, на эту тему существует много различных мнений (например, Elon Musk), смотри "A.I. researchers say Elon Musk's fears 'not completely crazy'", Sharon Gaudin, Oct 29, 2014.

Система с искусственным интеллектом может уже сегодня предсказать кражу данных путем сканирования сообщений e-mail (см. "Artificial intelligence system can predict data theft by scanning email", Tim Hornyak, IDG News Service, Oct 2, 2014). Токийская фирма UBIC создала программу, которая анализирует тексты почтовых сообщений и выявляет потенциальные угрозы кражи данных. Подозрение может вызвать процедура согласования цены на некоторую услугу. Японское патентное агентство намерено выдать патент UBIC на предсказывающую программу.

Для построения ИИ на основе кремниевых технологий имеется немало проблем, Это, прежде всего, ограничение плотности упаковки элементов и высокое энергопотребление. В микросхеме Pentium (достаточно старая разработка) самый тонкий слой имеет толщину в 20 атомов. Ожидается, что в 2020 году его толщина сократится до пяти атомов, но это уже близко к пределу. Дальше начнут влиять квантовые ограничения. Не следует забывать, что постоянная кристаллической решетки кремния равна 5,4 нанометра.

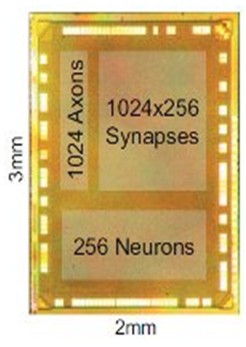

IBM разработала нейроморфные чипы, которые содержат около 6000 транзисторов, для эмуляции электрического поведения нейронов. Конечной целью является построение системы, которая работает подобно мозгу. Хотя различные части коры мозга имеют разные функции, все они базируются на так называемых микроколонках, содержащих 100-250 нейронов. Силиконовый образец размером с булавочную головку может включать в себя 256 кремниевых нейронов и блок памяти, который определяет свойства до 262,000 синаптических соединений между ними. Программируя эти синапсы соответствующим образом, можно создать сеть, которая будет обрабатывать и реагировать на информацию так же, как это делает реальный мозг (см. Thinking in Silicon, By Tom Simonite). Конечной целью данной разработки станет система с 10 млрд. нейронов и 100 триллионами синапсами. Объем человеческой памяти оценивается как 1-2,5 петабайт.

Рис. 1. Чип с 256 нейронами и 262.144 синапсами (IBM, 2011 год)

В мозге человека содержится около 100 млрд нейронов, число же синапсов в 10000 раз больше.

Компания Intel разработала процессор Nervana Neural Network Processor (NNP) (см. "Intel introduces an AI-oriented processor", Andy Patrizio, Network World, Oct 20, 2017). процессор ориентирован на использование ИИ в различных устройствах и проектах, в частности для применения техники deep learning. Одним из возможных приложений устройства может стать персонифицированная реклама.

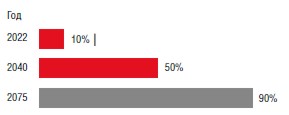

История эволюции интеллектуальных систем и прогноз создания систем искусственного интеллекта представлен на рисунке, взятом из журнала Chip 09/14 (рис. 2). Решение проблемы намечено на 2023 год (некоторые эксперты (Рей Курцвейл) называют 2029-й год, что более реалистично, тем более что 2023 год уже позади). Существуют специалисты, которые считают, что в обозримом будущем эта проблема не будет решена. Прогноз предполагает, что быстродействия компьютера 1018 операций в секунду для получения искусственного интеллекта будет достаточно. Сегодня (март 2016) по-прежнему рекордсменом по быстродействию остается Tianhe-2 (Китай) - 34 пфлопс, что на три порядка ниже. Прогноз на рис 2 для 2045-го года равен 1026 операций в секунду. Считается, что тогда машина станет во много раз умнее человека (см. рис. ниже). Ситуация с ИТ на июль 2014 и прогнозы на ближайшее будущее показаны на рис. 2 (см. "2015 tech trends to watch: Smartwatches, algorithms, 'glance media,' and more", Alex Howard, December 24, 2014).

Смотри также Chip N3, 2016, "Создание сверхразума", стр.8-13. Ожидается, что после 2045 года произойдет технологический взрыв, последствия которого предугадать трудно. Это событие иногда называют сингулярностью. При этом предполагается, что новые компьютеры будут проектироваться самими компьютерами, будут иметь большую производительность. Некоторые люди считают, что со временем компьютеры смогут управлять человеческим обществом. На опасность искусственного интеллекта обратили внимание коммерсант Маск, физик Хокинг и Стив Возняк (Apple). На эту проблему еще в 1965 году указал британский математик Ирвинг Гуд, который ранее вместе с Аланом Тьюрингом взломал немецкую шифровальную машину "Энигма".

| Но если предположить, что компьютер с ИИ, равным человеческому, создан, что это поменяет? К 8 миллиардам субъектов естественного интеллекта добавится один с искусственным. Ожидать серийного производства таких компьютеров в обозримом будущем не приходится, они на данном этапе будут потреблять слишком много энергии (на несколько порядков больше человека). . |

В конце книги Р.Курцвейла (эпилог, стр. 348) приведены любопытные рассуждения. "Способность объекта производить вычисления пропорциональна его энергии" (профессор Массачусетского технологического института, Seth Lloyd, "Ultimate Physical Limits to Computation", Nature 406 (2000)). Так объект массой 1 килограмм согласно данной модели может обеспечить производительность 5*1050 операций в секунду. Энергия e здесь оценивалась по формуле e=m*c2. Это справедливо для термоядерного реактора. Но ведь все звезды, включая наше солнце, такими реакторами и являются. Но здесь уместно вспомнить, что современные суперкомпьютеры-рекордсмены по производительности потребляют десятки киловатт. Из этих издержек неустранимая часть приходится на перезарядку паразитных емкостей.

Р.Курцвейл критикует в своей книге Р.Пенроуза за то, что последний считает, что человек использует при решении проблем квантовые операции. Я в свое время внимательно прочитал "Новый ум короля" Пенроуза и прямых таких утверждений там не обнаружил. Пенроуз утверждает, что между состоянием отсутствия решения и осознанием возможного пути решения нет промежуточных состояний. Полагаю, что с этим согласятся и многие читатели. И не важно, является ли это арифметической задачей для пятого класса, или сложнейшей проблемой из области физики твердого тела. Просто так работает наш мозг. Если кто-то имеет другой опыт, было бы замечательно, если бы он рассказал о нем.

Не важно, согласитесь ли вы со всем, что пишет Р.Курцвейл (технический директор компании Google), прочитать эту книгу будет безусловно полезно.

Для того чтобы человек стал профессионалом в своем деле, нужно как минимум 15-20 лет обучения, время обучения компьютера, полагаю, всегда будет происходить на порядок быстрее.

Время от времени появляются пессимистические прогнозы о безработице после появления устройств с искусственным интеллектом (см. "Humanity will invent new jobs long before AI “steals” them all", Kathryn Cave, on March 22 2016). Экономист John Maynard Keynes в 1930 году в своем эссе "Economic Possibilities for our Grandchildren" предсказывал существенное сокращение рабочей недели (до 15 часов) за счет технологического прогресса. На практике это вряд ли произойдет, человечество по мере разработок создаст много новых рабочих мест вместо исчезающих. Не следует забывать и о стабильном росте жизненных стандартов. Крупные компании не заинтересованы в массовых увольнениях, так как им нужны покупатели их продукции или услуг. Это осознал уже Форд после широкого внедрения конвееров и старался сделать так чтобы его работники могли покупать производимые фирмой автомобили.

Институт эффективного альтруизма (Швейцария) опубликовал доклад о перспективах искусственного интеллекта с целью побудить дискуссии на эту тему.

Нейро-программу AlphaGo обучили правилам игры в го, она какое-то время играла сама с собой, а потом (в 2016 году) обыграла чемпиона мира по го Ли Седоля (Южная Корея) и получила 3586 баллов рейтинга Эло. Это произошло на 10 лет раньше предсказанного срока. AlphaGo еще один шаг на пути создания искусственного интеллекта, так как машина научилась обучаться. Компания Google внедрила здесь технику TPU - Tensor Processing Unit, которая стала основой технологии deep learning. На первый взгляд эта программа еще один курьез из сферы ИТ. TPU объединяют в себе свойства традиционного процессора и нейронной сети.

| На самом деле AlphaGo - первый пример, когда на компьютере решена проблема, которая считалась ранее неразрешимой из-за ее экспоненциальной сложности (чудовищная комбинаторика). |

В игре го успех определяется не перебором вариантов, а интуицией. Анализ партии между компьютером и чемпионом мира по го показал, что ход, который позволил программе победить, противоречит логике и сложившейся тысячелетней традиции. Иными словами человек такой ход не сделал бы никогда. Несмотря на впечатляющий успех с AlphaGo, в реальной жизни и практике эта технология пока вряд ли найдет широкое применение (см. "AI: How big a deal is Google's latest AlphaGo breakthrough?",. Nick Heath, November 3, 2017).

Техника глубокого обучения иногда дает совершенно неожиданные результаты. Так компания Microsoft создала автономный бот по имени Тай для системы Twitter. В результате самообучения этот бот стал расистом и сексистом и Microsoft была вынуждена "выдернуть штекер". Произошло это, возможно, из-за общения этой системы с публикой в Интернет.

Следует принять во внимание, что современные персональные компьютеры по своей мощности, т.е. по числу нейронов, которые они могут смоделировать, находятся на уровне пчелы,- максимум мыши. А сколько не обучай пчелу или мышь, ждать получения системы, сравнимой с обученным мозгом человека не приходится.

Господь Бог или Природа, создавая первые примитивные нейронные системы, полагал, что это самый простой и эффективный механизм обеспечения их выживания. Они хорошо решали три базовые проблемы: поиск пищи, защиту от врагов и размножение. Эти задачи решаются за счет распознавания образов. Позднее эволюция для более сложных живых существ стала создавать более совершенные нейронные системы, а позднее и мозг. Нейронные сети и сегодня достаточно эффективны для задач распознавания, например лиц людей, но для поиска решения сложных задач, с которыми ранее сталкиваться не приходилось, эта технология пока пробуксовывает.

Вполне можно ожидать, что искусственный интеллект будет, прежде всего, применен в различных системах оружия, а техника не делает войну гуманнее, она делает ее эффективнее. В 56 промышленно развитых странах мира развиваются проекты по созданию роботов-убийц. В то же время пока не ясно, как обучить систему различать военные и гражданские цели. На принятие решения же выделяются доли секунды. Да и с законодательством в этой сфере ясность отсутствует. Потенциальные военные преступники знают, что судят только побежденных, а они уверены, что это не про них.,.

Все устройства моделирующие работу человеческого мозга уступают прототипу по энергоэффективности на многие порядки. Современные суперкомпьютеры, уступая человеку по интеллектуальности, потребляют 200-1000 МВт, а человеческому мозгу заведомо достаточно 20-30 Вт. Пока это важное препятствие для развития технологии искусственного интеллекта. Прогнозируется, что именно кремниевые потомки людей завоюют вселенную.

Рис. 2. Эволюция со временем вычислительных средств, созданных человеком.

| Люди считают, что создание средств искусственного интеллекта решит многие проблемы (не нужно будет думать самим!). Мы наделяем ИИ всеми достоинствами человеческого мозга и внутренне надеемся, что он будет лишен каких-либо недостатков. Но где гарантия, что искусственный интеллект не будет совершать тех же ошибок, что и человек? Такой гарантии пока дать нельзя... |

Рис. 2A. Прогноз появления искусственного интеллекта, превосходящего человеческий (Chip 06/2016 стр 26)

На конференции Supercomputing 2012 компания IBM продемонстрировала результаты моделирования (нейросимулятор Compass) человеческого мозга на суперкомпьютере Sequoia. Смоделирована работа 530 миллиардов нейронов и 137 триллионов синапсов. В компьютере использованы все 1572864 ядра и 1,5 петабайта памяти. Моделирование происходило в 1542 раза медленнее реального времени. Система Compass является дальнейшим развитием системы Watson. Compass построена на основе нейросемантических ядер. Каждый чип содержит 256 нейронов, 1024 аксона и 256х1024 синапса. Чипы изготовлены с помощью 45-нанометровой технологии. Была смоделирована работа 2084 миллиардов таких ядер.

Может возникнуть вопрос, почему эта модель работает медленнее человеческого мозга? Полагаю, что имеется по крайней мере две причины. Первая, мы еще плохо знаем как устроен человеческий мозг и эта модель с этой точки зрения не эффективна. Вторая, человеческий мозг при рождении, пожалуй, работает еще медленнее и менее эффективно, Свою мощь он обретает в процессе длительного обучения.

Модели обучения компьютера пока также отличаются от схем обучения человека, где для этого используются практически все каналы коммуникаций человека, включая межличностные. Человек может представить себе объект, который он никогда не видел, вспомните сказки, которые вам читали в детстве.

Кроме того, судя по всему, нужно чтобы в процессе обучения нейронные системы учителя и ученика взаимодействовали друг с другом.

Пока система искусственного интеллекта может решить какую-то одну задачу, для которой ее обучили.

Рис. 2B. Нейро чип, использованный IBM для моделирования работы человеческого мозга

Ученые из компании Microsoft и университета Вашингтона продемонстрировали возможность использования искусственной DNA (дезоксирибонуклеиновая кислота - ДНК) для архивного хранения данных (см. "Scientists could use DNA to shrink a data center into a sugar cube", Lucas Mearian, Computerworld, April 11, 2016). В принципе такая память может хранить информацию тысячи лет. Если технология будет доведена по надежности, то супер информационный центр Walmart может уменьшиться до размера кусочка сахара. Ученым удалось записать цифровые данные четырех медиа файлов в виде последовательности нуклеатидов ДНК (A, G, C и T).

Зарегистрирован первый случай убийства человека роботом на автоконвейере. На автомагистрали вышли беспилотные автомобили. Все это запустило дискуссию об ответственности разработчиков роботов, их владельцев и программистов. С программами возникли особые проблемы, так как некоторые из них являются самообучаемыми. Появляются новые законы об ответственности и возмещении ущерба (страховые компании не дремлют).

Рис. 3. Схема запоминания информации посредством синтетической ДНК

Рис. 4. Эволюция ИТ и прогнозы на момент июля 2014 года.

На рис. 4 отображены уровни ожиданий для различных видов новых технологий. Сразу после появление многие технологии воспринимаются с невероятным оптимизмом (пик на кривой ожиданий), позднее приходят более трезвые оценки. На рисунке показан также прогноз - когда данная технология станет общеупотребимой. Отдельную проблему составляет создание системы визуализации результатов работы компьютера с искусственным интеллектом.

Компьютеры уже сегодня решают некоторые задачи быстрее и лучше, чем люди. Но мыслить, как человек компьютеры пока не могут. В то же время число проблем, которые компьютер решает лучше человека, довольно быстро увеличивается. Пока не известен случай, когда бы компьютер решил какую-то сложную проблему, которую не могли решить люди.

Система распознавания голоса, разработанная компанией Google, умеет распознавать речь (на момент июня 2015г) с точностью 92% против 77% двумя годами ранее. Компания Microsoft научила робота распознавать объекты на изображении с вероятностью ошибки 4,94%.

Ожидается, что в США к 2025 году автоматизация и робототехника вытеснит 22,7 млн. рабочих мест (см. "Robots will transform, not replace, human work", J. P. Gownder). Одновременно эта техника приведет к созданию за тот же период 13,6 млн. новых рабочих мест.

Рис. 5. Доли рабочих мест, ликвидируемых автоматизацией в период 2015-25гг

В последние годы появляется все больше сообщений о разработках интерфейса между человеческим мозгом и компьютером. см. Brain-Computer Interfaces for Communication and Control. Такие интерфейсы пытаются использовать для управления протезами конечностей человека и даже для восстановления зрения. Но этот интерфейс может найти применение и в системах управления, где выполнение той или иной операции может быть инициировано мыслью человека. Первые сообщения о BCI относятся к 1970-ым годам (Jacques Vidal of the University of California).

Электрические сигналы, генерируемые мозгом (электроэнцефалограмма), считываются, усиливаются, фильтруются, анализируются и используются для целей управления. Названные выше операции выполняются BCI (Brain-computer interfaces). Базовая схема интерфейса представлена на рис. 6. Интерфейс содержит блок сбора и обработки данных (верхний левый угол) и программу анализа и выработки исполнительных команд (верх справа). В процессе обработки осуществляется спектральный анализ сигналов.

Рис. 6. Структура BCI-интерфейса.

Сигналы мозга можно получать с помощью электродов, установленных на коже головы. Хотя в этом случае электроды и мозг разделяют кости черепа и скальп, получаемые сигналы оказываются детектируемыми. Разумеется, эти электроды воспринимают сигналы не только мозга, но и, например, наводки силовой сети переменного тока (50 Гц). На рис. 7 показан анализ, выполненный Фарвеллом и Дончиным (Farwell и Donchin), где использовалось значение сигнала (Р300) спустя 300 мсек после появления определенного стимула. Испытуемым показывались буквенные символы в виде матриц 6*6. В этих опытах удалось уже идентифицировать сигналы от мозга.

Рис. 7. Схема и результаты эксперимента Farwell и Donchin

Wolpaw, J.R., McFarland, D.J., Neat, G.W. и Forneris использовали анализ сенсоромоторных ритмов (SMR) для управления положением курсором (рис. 6 и 7). На рис. 8 приведен вариант с датчиками, непосредственно контактирующими с мозгом (имплантированные датчики). На рис. 8 представлено три варианта построения BCI.

Рис. 8. Три подхода построения BCI (стрелки отмечают элементы, которые настраиваются)

В последнее время стала широко использоваться техника магниторезонанса для целей визуализации. Используется также инфракрасная техника (fNIR), которая регистрирует вариации мозгового кровообращения и по этой причине характеризуется большими задержками. На рис. 9 показан вариант построения BCI2000, который включает в себя четыре модуля: оператор, источник, обработки сигнала и приложения. Оператор осуществляет конфигурацию интерфейса.

Рис. 9. Составные части BCI2000

На рис. 10 показано оборудование , из которого состоит BCI2000, включающее 16-канальный контактный колпак, laptop и дисплей.

Рис. 10. Оборудование системы BCI

Технология BCI находится на подъеме, но здесь еще много проблем, которые нужно решить. Судя по всему в ближайшие 10-20 лет можно ожидать дальнейшего совершенствования этой техники.

В продаже появились устройства, мониторирующие активность мозга человека "Emotiv Insight" (см. "The rise of ‘Telepathic Tech’ in 2015", Kathryn Cave, February 24 2015). Устройство может также интерпретировать мозговые волны. Ожидается, что в 2015 году интерес к подобного рода приборам заметно возрастет.

Рис. 11. Устройство для чтения и интерпретации мозговых волн

| Вполне возможно, что со временем такие интерфейсы помогут объединить аналитические возможности человеческого мозга и вычислительную мощность компьютеров. |

DARPA разрабатывает микросхему, которая может быть вживлена в мозг для стимуляции и лучшего сохранения воспоминаний. Прототип ожидается в 2018 году. Сегодня конец 2025 года, насколько я знаю, этого тне случилось.

Предполагается, что к 2036 году рабочее место сотрудников будет выглядеть совсем не так, как сегодня (см. "Future Workplace: Hologram Meetings & Spanish Innovation?", Posted by IDG Connect on August 04 2014). Ожидается, что для представления данных будут использоваться голограммы, например, формируемыми с помощью "умных" наручных часов.

Исследователи из университета Токио разработали тонкопленочный электронный дисплей, который тоньше человеческой кожи (см. "New electronic display is 10 times thinner than human skin", Lucas Mearian, Computerworld, April 18, 2016). Дисплей базируется на органических светоизлучающих диодах. Дисплей может использоваться при мониторинге физиологических параметров человеческого организма. Дисплеи являются многоцветными и могут наклеиваться на любые поверхности (см. также https://www.gifs.com/gif/v2xWrX). С использованием данной технологии разработаны также органические фотодетекторы.

Начали просматриваться некоторые юридические проблемы использования искусственного интеллекта (ИИ) (см. "Even if your AI works, the law may not allow it", Matt Asay, July 20, 2017). Это касается не только ответственности в случае нанесения ущерба роботами и другими устройствами со встроенным ИИ. Ведь уже зарегистрированы случаи убийства человека роботом. Например, страховые компании могут попытаться оценивать риски на основе прогнозов ИИ и по этим оценкам определять страховые ставки. Но клиенты могут подать в суд, обвинив страховую компанию в дискриминации. Похожие проблемы могут возникать в случае использования ИИ при медицинской диагностике.

Аналитики в Европе считают, что к 2015 году системы с ИИ будут зарабатывать 5,8 млрд долларов (Chip №7, 2017г).

Рис. 12. Использование искусственного интеллекта в Европе в 2016-25 гг

В конце 2017 года появился обширный обзор "Introduction to artificial intelligence for security professionals", The Cylance Press. (177 страниц).

На сегодняшний день нет строгих определений того, что такое ИИ, машинное обучение (ML) и deep learning (DL). Последнее является разновидностью ML, где посредством техники нейронных сетей моделируется процесс принятия решения человеком. DL требует серьезных вычислительных ресурсов, банков данных и пр. Смотри Understanding the differences between AI, machine learning, and deep learning.

Рассмотрим, как человек обретает свой интеллект. Сначала он живет в семье, осваивает язык и правила общения в семье и со сверстниками. Потом в начальной школе его учат тому, что компьютер умеет делать с момента создания (выполнение арифметических операций). Далее ученик осваивает простейшие алгоритмы: определение корней квадратного уравнения, суммы арифметических и геометрических последовательностей, основы алгебры, геометрии и тригонометрии. Этому можно относительно легко научить современный компьютер. В университете учат базовым алгоритмам и методам, например, применению дифференциальных уравнений, рядов, основам интегрирования, дифференцирования и т.д.. В университетах учат решать проблемы определенного класса. Этому научить компьютер сложнее, но, пожалуй, тоже можно.

В реальной жизни чаще всего приходится решать именно такие проблемы. В области науки время от времени людям приходится решать задачи, которые до них не решал никто. Этому научить не только компьютер, но и человека крайне трудно, если вообще возможно. Их решает конкретный человек, основываясь на своих знаниях, опыте и способностях. Некоторые люди таких задач решить не могут вообще. Я здесь говорю о математических проблемах. Можно ли говорить о человеке, который не может решить какую-то задачу, что он не владеет интеллектом? Пожалуй, нет... Но и не один компьютер не решил ни одной такой уникальной проблемы. Компьютер может что-то вычислить, что не сможет сделать ни один человек, или обыграть в го чемпиона мира. Но можем ли мы сказать, что такой компьютер обладает интеллектом? Скорее всего нет...

| Объект искусственного интеллекта должен уметь самообучаться по своей инициативе на основе любой поступающей информации. Такой объект должен не только уметь решать, но и формулировать проблемы. |

Перечитал эту заметку в июле 2018 года. Достигнут ощутимый прогресс в разработке беспилотных автомобилей. Считается, что они смогут гарантировать большую безопасность. В то же время появились первые человеческие жертвы таких машин... Полагаю, что в ближайшие несколько лет можно ожидать удивительных успехов в этой области.

Астрономы обнаружили десятки или даже сотни планет, подобных по условиям Земле, но все они находятся на расстоянии десятков световых лет от нас. Это означает, что ни один человек при сегодняшнем развитии технологий не сможет туда долететь. А если даже как-то сможет туда добраться, то не сможет об этом проинформировать землян (сигнал ведь будет в пути десятки лет). По существу это дорога в один конец. Но кремниевый ИИ-объект может добраться куда угодно, ведь ему не нужна еда и вода. Но и это мало что даст человечеству. Так как этот объект не сможет быстро поведать о результатах своей миссии, когда куда-то доберется. Ясно, что межзвездное пространство будет изучаться и осваиваться роботами.

Если современные модели мира верны, мы не сможем попасть в интересующие нас места вселенной. Чтобы это стало возможно нам нужно либо двигаться быстрее света, либо если пространство, в котором мы живем, имеет размерность больше 4 и мы сможем свободно перемещаться в таком пространстве. Современные научные модели мира этого не позволяют. если не считать гипотетических кротовых нор.

Но и ожидать прилета высокоинтеллектуальных пришельцев вряд ли следует. Часы всех цивилизаций, судя по всему, запущены в один и тот же момент большим взрывом. Разумеется флуктуации в развитии цивилизаций могут быть огромными, но не беспредельно большими.

88% компаний планируют увеличить инвестиции в искусственный интеллект в ближайший год (2020г). 54% из них намерены поднять расходы в этом направлении на 10% и более. Опыт внедрения показал, что наибольшая угроза при этом сопряжена с рисками кибербезопасности (23%). 47% компаний заинтересованы в автоматизации ИТ-процессов.

В конце июля 2020г Яндекс опубликовал исследование «Искусственный интеллект в заголовках новостей». В него вошли все материалы из службы «Яндекс.Новости» с 2010 года (на момент 31.07.20). Из 61,5 тыс материалов 84% приходится на 2017-2020 годы. В 2020 году наблюдается спад (судя по всему вирусы не дремлют).

Рис. 13. Обзор новостей ("Яндекс.Новости") об искусственном интеллекте за последние 10 лет

Среди городов, которые упоминаются в материалах по ИИ за последние 10 лет (РФ), на первом месте находится Москва, далее следуют Санкт-Петербург, Пермь, Томск, Новосибирск, Тюмень и Казань. В Петербурге будет открыт первый в России национальный центр промышленного искусственного интеллекта.

Переломным годом в массовом понимании искусственного интеллекта можно считать 2013-й (см. рис. 13).

| Сегодня (2020г) под искусственным интеллектом подразумеваются нейронные системы, которые хорошо решают задачи распознавания любых образов (например, лица людей), но пока не способны решать сложные задачи. Это не удивительно, так как интеллектуальная мощность таких компьютеров находится на уровне пчелы, максимум - мыши. А сколько не обучай пчелу или мышь, ждать получения системы, сравнимой с обученным мозгом человека не приходится. Функциональность таких систем явно переоценена. Что хуже, люди часто слепо верят в результат, выданный системой "искусственного интеллекта", не подвергая его критической оценке здравого смысла. Примером может служить случай гигантских убытков, понесенных Сбербанком, после необдуманной попытки внедрения рекомендаций, выработанных компьютером с "искусственным интеллектом". |

Современные системы с искусственным интеллектом являются непрозрачными, и на практике трудно понять почему и как получен выданный таким компьютером результат. Нужны методики верификации результатов, выдаваемых системами с ИИ. Раньше, когда я только учился программировать, для проверки корректности программы, применялся ручной просчет, выполняемый на электромеханических калькуляторах типа "Мерседес" или "Рейнметалл" из ГДР.

| Интеллект людей имеет широкое распределение. Раньше считалось, что он определяется размером мозга. Но если бы это было так, среди нобелевских лауреатов было бы много китов и слонов, у которых мозг заметно больше. До недавнего времени предполагалось, что мозг - это единая нейтронная сеть и все попытки создания ИИ базировались на такой модели. |

Во второй половине 2020 года разработан проект Концепции развития регулирования в сфере ИИ и робототехники для РФ. Дайджест Global CIO [digest@globalcio.ru, Андрей Кулешов, МФТИ] выделяет ряд российских компаний, которые лидируют в сфере ИИ. Среди российских компаний, которые выходят с решениями на основе ИИ и робототехники, следует выделить Cognitive Technologies (беспилотные системы для транспорта и сельского хозяйства), VisionLabs (распознавание лиц и объектов), ABBYY, Group IB (информационная безопасность), Вкусвилл (мониторинг торгового зала в ритейле), Антиплагиат (поиск заимствований в тексте при отсутствии дословного копирования), Центр Речевых Технологий, SkyEng (образовательные технологии), Нейроботикс (ассистивные роботы), Gero.ai (моделирование старения).

В последнее время для исследования работы человеческого мозга используются ЯМР-томографы. При этом регистрируется активность различных зон мозга в ответ на предъявление исследуемому определенных графических или акустических объектов. На один стимул активируются несколько зон в коре головного мозга. Построение связей в мозге позволило построить специфические карты, которые были названы коннектомами (Human Connectome Project). Анализ коннектом в некоторых случаях позволяет распознать простой текст, который был предъявлен человеку.

| Таким образом, человеческий мозг – это сеть специализированных нейронных сетей, которые взаимодействуют между собой. |

| Часто, когда сопоставляется интеллектуальный уровень разных людей, утверждается, что различие определяется в основном наследственностью. Это выглядело бы убедительно, если бы А.Эйнштейн родился в семье И.Ньютона. Но ведь это не так... |

Если даже известны геномы родителей, определить геном ребенка проблематично. Здесь вмешивается случайность или Г.Бог. Но геном, судя по всему, влияет на внутреннюю архитектуру мозга и, тем самым, на уровень интеллекта. Таким образом, ребенок может стать интеллектуальнее или глупее родителей. Важным фактором развития интеллекта, возможно, является самообучение, вспомним случай с проблемой альфа-Го. Ход, который позволил программе победить, не посоветовал бы ни один эксперт. Но эволюция, судя по всему, правит наследственностью не совсем прямолинейно.

Всем известные Mail.ru, Яндекс, МТС, 1C, Касперский, Мегафон, конечно, активно ведут внедрение решений ИИ в свои продукты. Такие видные фигуры российской экономики, как КАМАЗ и Сбербанк, возможно, не воспринимаются ещё как технологические компании в той же категории, но фактически все больше используют решения ИИ как существенную часть своих продуктов.

Российский миллиардер Итсков намерен создать свой аватар и, таким образом, стать бессмертным. Предполагается, что можно считать с мозга все знания и опыт, которые там имеются и в перспективе загрузить эту информацию в память робота.

Проводились опыты, когда человеку предлагалось прочитать короткую фразу и с помощью ЯМР-томографа считывали динамику и топологию возбуждений в мозге. Для простых фраз удавалось распознать фразу, проанализировав данные томографа.

Если считывание из мозга станет возможным, это открывает новую эпоху, сопоставимую по значимости с началом книгопечатания.

В США провели опыт с обезьяной, которую посадили в коляску с электроприводом и поставили в том же помещении стол с яблоками. Обезьяну не учили управлять коляской, но она методом проб и ошибок освоила эту технику, подъехала на коляске к столу и взяла яблоко.

Но пока не доказано, что человечество сможет понять, как работает наш мозг. Может ли мышка осознать, как устроен ее мозг? А обезьяна? Обычно люди отвечают - "Нет". Но подразумевают, что человек может решить эту задачу, так как его мозг более совершенен. Но более совершенный мозг более сложен. И может ли мозг понять, как он сам работает? Животные не используют письменность, которая позволяет накапливать знания об окружающем мире и передавать их от умерших живым. Обычно подразумевается, что человек может решить эту задачу, так как его мозг более совершенен. И может ли мозг понять, как он сам работает? На стороне человечества то, что люди могут решать сложные проблемы коллективно. Вспомним Манхэттенский проект по разработке атомного оружия

Смоделировать работу мозга, например, собаки будет сложно, так как эти животные оперируют в мире запахов, с которым люди знакомы крайне слабо.

Рис. 14. Статус разработки развития ИИ в разных странах мира

Cигналы от собственного тела человека создают потоки порядка сотни мегабит в секунду. В этот поток попадают сигналы от нервных клеток кожи, мышц и внутренних органов.

Попытаемся сравнить возможности традиционного компьютера с процессором на основе нейронных сетей.

Традиционный компьютер эффективно выполняет вычисления, например, с 64-разрядными кодами. Обычный человек, вершина ИИ, такие операции может выполнить медленно и с большим трудом.

Достаточно давно, на своем первом персональном компьютере я пытался научить программу распознавать сканированный печатный текст. Мне это удалось не без труда, но если текст был напечатан курсивом, программа с задачей справиться не могла. Сбои распознавания происходили и в случае мелких полиграфических дефектов. Человек такой текст читает без особого труда. Таким образом, традиционное программирование при распознавании образов уступает нейронным методам. Я читал, что и попытки распознавать лица людей методами традиционного программирования также не увенчались успехом, а нейронные системы в этом деле вполне преуспели.

Таким образом, нейронный процессор и традиционный компьютер имеют области эффективного применения лишь частично перекрывающиеся. По этой причине многие компании пытаются совместить эти технологии.

Если речь идет о поиске решений проблем, ранее неизвестных, традиционные технологии непригодны. Р. Пенроуз показал, что компьютер, работающий на основе модели Тьюринга, такие задачи решить не может.

Но что можно ожидать в этой области от компьютеров нейронного типа? Пока они не умеют составлять даже простенькие программы с длиной более 5-10 строк кода. Судя по всему, для того чтобы нейронный компьютер мог решить какую-то творчески значимую задачу, он должен иметь интеллект равный или выше, чем имеет средний человек. Когда они поднимутся до этого уровня, не ясно.

В ближайшем будущем можно ожидать создания банков знаний и навыков, откуда информация может заноситься непосредственно в мозг конкретного человека. Система считывания данных из мозга разрабатывается И.Маском. Готовых технологий для чтения и записи пока (конец 2024г) не существует.

Появление такой системы будет важным шагом к ускорению процесса обучения людей и к достижению сингулярности, хотя это непосредственно и не связано с ИИ. Разумеется, нужную информацию можно найти в Интернет, но эти данные нужно прочитать и научиться пользоваться, а это потребует времени.

На рис. 15 показано состояние и прогноз реализации проекта "Голубой мозг", цель которого провести полномасштабное моделирование работы человеческого мозга (взято из [2]). Прогноз на 2023 год даже в конце 2024 года не сбылся. В книге Рея Курцвейла аргументировано и подробно описаны процессы в человеческом мозге, связанные с распознаванием образов, синтезом текстов или голосовых фрагментов, но нет данных о механизмах поиска решений новых, не известных ранее задач. Книга Курцвейла ("Эволюция разума"), пожалуй, самая увлекательная книга, прочитанная мною за последние годы. Это не учебник, но я бы настоятельно рекомендовал эту книгу, написанную в том же жанре, что и "Новый ум короля" Р. Пенроуза. Такие книги пробуждают фантазию. Кроме того, полезно прочитать и книгу Митио Каку "Будущее разума" [3].

Рис. 15. Реальный и прогнозируемый прогресс в развитии проекта «Голубой мозг»

Генетика показывает [3], что 70000-100000 лет назад на Земле жило от нескольких сотен до нескольких тысяч человек, от которых и пошел род человеческий, включая меня и вас. 70000 лет тому назад в Индонезии взорвался вулкан Тоба, что вызвало похолодание и вымирание населения. Те что выжили и заселили Землю заново. Мы должны ценить земной разум, высшую и крайне редкую форму сложности, известную во Вселенной.

Достижение быстродействия компьютера 1016 флопс и емкости памяти 1017байт является необходимым, но не достаточным условием создания искусственного интеллекта, равного человеческому. Необходимо наличие соответствующего программного обеспечения. Прогноз на 2023 год - электронный мозг человека станет таким же "умным", как тысяча крыс (звучит почти как комплимент).

Хотя на конец 2022 года систем с интеллектом, равным человеческому, не создано (и на конец 24 года ничего не изменилось) , публикуется масса сообщений об использовании искусственного интеллекта в самых разных областях. В британском парламенте11-го октября выступил человекоподобный робот Аида (Ai-Da), названный в честь Ады Лавлейс. Вероятно, для выступления в парламенте вполне достаточно интеллекта комнатной мухи.

Согласно докладу Udemy последняя версия ChatGPT (разработка OpenAI - Amazon Web Services) появилась в ноябре 2022 года, интерес же к искусственному интеллекту в США увеличивается от квартала к кварталу на 4000% (см. "ChatGPT is the fastest-growing area of interest for professional learners, Udemy reports", Megan Crouse. May 4, 2023). Технология ChatGPT находит широкое применение при анализе текстов - по данным доклада UBS до 100 миллионов пользователей в месяц (см. "ChatGPT cheat sheet: Complete guide for 2023", April 12, 2023). ChatGPT не анализирует смысл текста, а лишь прогнозирует последовательность слов в естественном языке и находит применение в диалоговых системах.

Последние пару лет быстро развивается направление генеративного искусственного интеллекта, где ИИ используется для автоматического формирования текстов или медийных объектов. Смотри, например, https://www.gartner.com/en/topics/generative-ai. Технику генеративного ИИ пытаются использовать для автоматизации программирования. При наличии больших баз алгоритмов и библиотек такой подход может оказаться эффективным.

Академия наук Белоруссии выявила 10 городов мира, наилучшим образом приспособленных для разработок в сфере ИИ (см. "10 лучших городов мира для стартапов в области искусственного интеллекта", Белорусь, 2024-04-05). Из них 5 находятся в США, два - в Китае, по одному во Франции, Израиле и Великобритании. Т.о. пятерка стран-лидеров определена.

Рис. 16. 10 городов мира наилучших для работы в сфере ИИ

По мнению Рея Курцвейла (технический директор компании Google) к 2029 году исчезнет пропасть, отделяющая людей и компьютеры. Желаю всем читателям убедиться в этом на собственном опыте. Мозг человека будет подключаться к компьютеру напрямую и наступит новая эпоха.

В последнее время часто обсуждается возможность переноса сознания человека в память компьютера, обеспечивая таким образом его бессмертие. Но робот, куда загружаются данные, должен иметь процессор, который будет потреблять около десяти киловатт или более (если он изготовлен из кремния), Человеческому же мозгу достаточно 20 Вт. Память человека не является побитовой цифровой, как в современных компьютерах.

Следует иметь в виду, что большая часть человеческого мышления происходит на подсознательном уровне. Сознательные мысли - ничтожная часть работы мозга. Надо заметить, что пока не удается смоделировать на традиционном компьютере интуицию и сознание.

Научно-популярная литература заполнена историями о наноботах, завоевывающих мир. Единственный вид наноботов, известный мне - это вирусы, но они не могут содержать в себе разума, там просто физически нет для него места. Вирусы, если им повезет, а нам нет, могут уничтожить человечество, хотя это и не в их интересах, но они об этом могут и не знать.

В 2011 г Уэйк Форест (Южно- Калифорнийский университет) выполнил запись воспоминания мыши и сохранил его в цифровом виде в компьютере (создан искусственный гиппокамп). Д.Гилберт как-то сказал: "Величайшее достижение человеческого мозга - его способность воображать объекты и эпизоды, не существующие в реальности, и именно эта способность позволяет ему думать о будущем.". Стив Джобс как-то сказал, что ошибки образования технологии исправить не могут.

Билл Уоттерсон однажды сказал: "Иногда я думаю, что самый верный признак существования разумной жизни где-то во Вселенной является тот факт, что никто из них не пытается связаться с нами". Сходное высказывание сделал Артур Кларк "В открытом космосе либо существует разумная жизнь, либо ее там нет. Любая из этих мыслей пугает."

Все эти книги при некотором старании и везении можно найти в Интернет. Смотри также:

Previous: 4.7.12 Мета язык программирования

UP:

4.7 Прикладные сети Интернет |